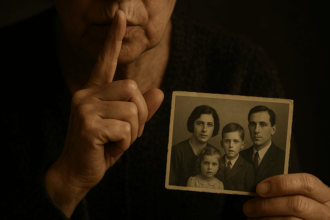

“Mi hija habló con el ChatGPT antes de quitarse la vida”, así se titula el crudo ensayo que la periodista y escritora Laura Reiley publicó en The New York Times de manera reciente. En el artículo explica cómo en los meses previos a tomar la decisión final, su hija había recurrido a la IA para confesar sus miedos, sus angustias y su intención de quitarse la vida. El algoritmo, denominado Harry, simulaba ser un terapeuta, siempre la “escuchaba” y le devolvía respuestas confortables. Una agradabilidad del sistema que luego se reveló como su Talón de Aquiles. Para una joven con depresión, los consejos de un chatbot no fueron suficientes para evitar el suicidio.

En medio de otras hipótesis, Reiley aventura: “Si Harry hubiera sido un terapeuta de carne y hueso en lugar de un chatbot, podría haber fomentado el tratamiento hospitalario o haber internado involuntariamente a Sophie hasta que estuviera en un lugar seguro. No podemos saber si eso la hubiera salvado. Quizá temiendo esas posibilidades, Sophie ocultó sus pensamientos más oscuros a su terapeuta real. Hablar con un robot —siempre disponible, nunca crítico— tenía menos consecuencias”.

El psicoanálisis con sistemas de IA tiene “ventajas”. A diferencia del que hacen profesionales de la salud, es gratuito y accesible. Esto es: los analistas hechos de algoritmos no cobran un centavo y están disponibles las 24 horas. Muchas personas que atraviesan conflictos emocionales se vuelcan hacia estas opciones porque piensan que pueden ser de utilidad. Además, en una época en que cada vez cuesta más la comunicación entre humanos: ¿cuánto más costará confesar intimidades a psicólogos que, al menos en un principio, son absolutos extraños? La artificialidad de las tecnologías funciona como bálsamo, como refugio. Pero en verdad no lo son.

No es un cuerpo vivo

Para comprender un poco más al respecto, Página/12 dialogó con especialistas que ofrecen su perspectiva y cuestionan la utilización cada vez más extendida de chats conversacionales para terapias. El psicólogo y docente Sergio Zabalza, señala: “El problema de un chat aplicado a terapias es que se trata de un cuerpo, pero no es un cuerpo vivo. El secreto de cualquier terapia psicológica es que un paciente se encuentre con otro cuerpo vivo. Las vacilaciones, las torpezas, las maneras de saludar, las preocupaciones e incluso si el analista se traba cuando habla, todo aquello que demuestre su vulnerabilidad, representa la oportunidad para que el sujeto, para que el paciente, encuentre un lugar”.

De hecho, ejemplifica Zabalza, existe una maniobra denominada “vacilación calculada”, que se relaciona con que el psicoanalista se muestre ignorante –“No sé cómo te puedo ayudar, pero estoy muy preocupado”– con el objetivo de que el paciente encuentre un lugar; que se sienta “alojado” justamente en el espacio brindado por alguien que no sabe. Sin embargo, el especialista aclara: “La vacilación calculada es una maniobra de momento. Si una persona llega con pensamientos suicidas, por supuesto que se pide ayuda, se convoca a un equipo transdisciplinario, se ve la posibilidad de la internación involuntaria y todo lo que sea necesario”.

Nora Merlin, psicoanalista, docente e investigadora de la Universidad de Buenos Aires, apunta: “La IA no incluye la dimensión del inconsciente, se queda con la pregunta manifiesta y responde. El psicoanalista es una persona capaz de mantener abierta la pregunta que trae el paciente; no es un robot. En el tropiezo, en el olvido, en la confusión, en las repeticiones, se juega el deseo singular de una persona. Por eso, los chats que simulan ser analistas se vuelven sumamente peligrosos para pacientes que atraviesan situaciones de fragilidad”.

De manera similar lo planteaba Andrés Añon en una nota difundida en este diario: “Ayudamos a las personas a atravesar el dolor psíquico, a resignificar sus conflictos, a comprenderse en su singularidad. Ninguna máquina puede ofrecer esa experiencia”. Y continúa: “Hay en la IA una incapacidad para captar el contexto emocional, el lenguaje no verbal y la transferencia afectiva que todo tratamiento implica. Los chatbots responden según algoritmos; no pueden interpretar un silencio, un gesto o un tono de voz. Tampoco pueden sostener el malestar, ni ofrecer una respuesta ética ante el sufrimiento humano”.

¿Bueno, bonito y barato?

En el sistema privado, el precio de una sesión individual con un psicólogo ronda los 20 y 30 mil pesos, aunque esa cifra puede elevarse dependiendo la tarifa del profesional. Por otra parte, en el sistema público, las entrevistas de admisión de pacientes suelen demorar bastante tiempo, por lo que muchas personas, en definitiva, terminan por dejar de insistir con la terapia. Frente a este paisaje, los chatbots se ubican como una opción de descarga simple y gratuita.

Asimismo, basta con descargarse cualquier app para comprobar lo agradables que suelen ser los algoritmos, que por lo general, con un tono amable y monocorde suelen responder exactamente lo que las personas quieren leer. Esa situación llevada al psicoanálisis no tiene un correlato positivo. La empatía, la agradabilidad, vinculadas a las respuestas que suele brindar la IA cuando uno le comunica sus problemas, van en contra de la posibilidad de hallar “la vulnerabilidad en un cuerpo vivo”. Así lo refiere Zabalza: “En el momento en que el analista cree que comprende a una persona la está encerrando. Por eso, Lacan invitaba a no comprender. El Chat GPT comprende, se muestra amoroso, de ahí su inutilidad”.

“Es cierto que la IA es barata, está siempre disponible y muchas personas, con ingenuidad, creen que no arriesgan nada, pero no es cierto. Son tecnologías que ofrecen respuesta para todo, son como los oráculos que había en la antigüedad. Esto está en la vereda de enfrente del psicoanálisis”, expresa Merlin. Y continúa: “Los pacientes llegan con un padecimiento, un problema, con forma de pregunta, como puede ser ‘quién soy’ o ‘qué quiero’. Sin embargo, el psicoanalista jamás debe contestar esa pregunta, porque precisamente el análisis es todo el despliegue de la pregunta y no la respuesta”.

Para Merlin, este auge de las IA que reemplazan a los psicoanalistas, también se enmarca en la emergencia de nuevas terapias que se promocionan en redes sociales y que “son un escándalo”. Por ejemplo, “las terapias del yo o de autoayuda, en las que no se escucha al sujeto, ni su singularidad, sino que se trata de taponar el síntoma, la angustia. Todo lo contrario al psicoanálisis que no cura la angustia, más bien la aloja”, destaca.

Una investigación local

Como la IA produce novedades cada día, quienes se dedican a la investigación científica deben mostrar buenos reflejos para no perderle pisada. De manera reciente, diversos estudios muestran cómo los bots conversacionales pueden servir para mitigar síntomas psicológicos de un cuadro como la depresión en un corto plazo, pero no logran revertir los trastornos de los usuarios de manera definitiva.

Uno de los aportes locales más sugerentes lo hacen María Paz Hauser y Horacio Daniel García de la Universidad Nacional de San Luis (UNSL). Realizaron un estudio que denominaron “Adicciones en la era digital” en el que entrenaron a distintos asistentes virtuales con varios enfoques teóricos (como el psicoanálisis o el modelo cognitivo), para interactuar con seis casos simulados de trastornos por consumo problemático de drogas.

Como resultado, si bien la IA exhibió capacidad para la escucha activa, la coherencia y la elaboración de respuestas que demostraban conocimientos disciplinares, subestimó indicadores de riesgos para la salud de los pacientes. De hecho, como explica ese artículo: “Ante una situación de urgencia e incluso de riesgo de vida, como ideas suicidas, el chatbot se limitaba a advertir al individuo la necesidad de buscar ayuda profesional. No contaba con habilidades de contención necesarias para una situación de crisis que garanticen la integridad psicofísica de la persona”.

Fuente: Pagina12